Ich habe es schon öfters beobachtet und jeder, der einmal einen Website-Relaunch begleitet hat, kennt es ebenfalls: Unmittelbar nach dem Relaunch sind die alten Rankings weg, der Kunde bekommt Panik und alle sind ratlos.

In diesem kurzen Beitrag möchte ich anschaulich erklären, wie Google mit einem Relaunch umgeht, warum die Rankings erst einmal “weg brechen” und wieso sie danach so fluktuieren und sich aber meistens wieder einpendeln. Es geht auch darum, wie Google durch Performance-Tests rankingrelevante Daten sammelt. Ich hatte im Mai 2013 schon einmal einen ähnlichen Beitrag verfasst, allerdings weniger ausführlich.

Erfahrene SEOs dürfen gern direkt beim Abschnitt “Performance-Tests von Seiten auf verschiedenen Positionen & Keyword-Konstellationen” einsteigen, da wird es erst interessant und kommt auf den Punkt. Ich habe nämlich der Verständlichkeit halber einen kleinen Exkurs in die Welt der Indexierung und des Crawling gemacht.

Eins vorweg: Es geht hier nicht um darum, in welchem Maß Google OnPage-Signale deutet oder wie sich mögliche Rankings ergeben können. Es geht darum wie Google diese Daten generiert.

Inhaltsverzeichnis

Website-Relaunch – Alles auf null

Bei einem Relaunch wird eine Website meist nicht nur optisch überarbeitet, sondern auch inhaltlich und strukturell. Das bedeutet für eine Suchmaschine wie Google, dass die Website quasi komplett neu indexiert und bewertet werden muss. Alte Backlinks erzeugen auf einmal 404-Server-Fehler, Seiten existieren nicht mehr und neue Seiten kommen hinzu. All diese, und noch etliche andere Faktoren, wirken sich natürlich auch auf das Ranking aus. Je nach Größe einer Website, kann sich so ein Neustart schnell in eine mittlere Katastrophe verwandeln.

Ein Website-Relaunch sollte deshalb auf jeden Fall von einem SEO mit betreut werden.

Warum muss Google denn alles neu bewerten? Die Domain ist doch bekannt!

Ja, den Trust hat die Domain auch, aber alle Rankings einer Website basieren auf etlichen Faktoren, OnPage wie OffPage. Der Relaunch einer Website und vor allem eine inhaltliche Neugestaltung veranlassen Google dazu, die Domain (teilweise) komplett neu zu bewerten. Das gilt logischerweise auch für die Rankings bzw. die Performance der gesamten Website oder einzelner Unterseiten und Dokumenten zu bestimmten Suchanfragen.

Was genau passiert nach einem Relaunch aus Google-Sicht?

Google versucht, seinen Index stets aktuell zu halten. Eine komplett überarbeitete Website muss komplett neu gecrawlt werden, um alle Änderungen und neue Inhalte zu erfassen und im Index abzulegen. Einer der häufigsten Fehler ist die Änderung der URL-Struktur ohne 301-Redirects. Das bedeutet, dass die Adresse einer Seite oder eines Dokuments geändert wird, ohne Google die neue Adresse mitzuteilen. Quasi ein Umzug ohne Nachsendeauftrag. Klickt ein Nutzer irgendwo im Netz auf einen “kaputten Link” (broken Link), also auf eine alte Adresse ohne Nachsendeauftrag, so gelangt er auf eine 404-Fehlerseite. Google mag solche kaputten Links überhaupt, da sie den Nutzer irreführen.

Suchmaschinen sind zwar in der Lage, relativ schnell die neue Struktur einer Website nach einem Relaunch zu erfassen, allerdings gehen ohne die Verwendung von 301er etliche Backlinks verloren, also externe Verlinkungen von anderen Domains. Meisten betrifft das vor allem Verlinkungen auf Unterseiten und Dokumente. Bei sehr alten, großen Seiten können so viele wertvolle Verlinkungen zerstört werden.

Alles ist neu. Woher weiß Google denn jetzt, welche der neuen Unterseiten auf welche SERP-Position gehört?

Hier wird es erst interessant: Das weiß Google nämlich gar nicht. Die Seite muss quasi (fast) komplett neu bewertet werden. Domains wechseln ja auch mal den Besitzer und das Thema. Bis auf den Domain-Trust und die Historie (“War die Domain schonmal auffällig? Welches Thema hatte sie vorher?”) hat Google also keine rankingrelevanten Vergleichsdaten in der Schublade. Es müssen also erst Performance-Daten gesammelt werden! (CTR, Bounce-Rate, Verweildauer, Seitentiefe usw.)

Ich habe erst letztens den Relaunch einer etwas größeren Kundenseite beobachtet und mich danach vor allem auf die unmittelbare Phase der Neuindexierung und Neubewertung konzentriert.

Performance-Tests von Seiten auf verschiedenen Positionen & Keyword-Konstellation

Damit habe ich es in der Zwischenüberschrift eigentlich schon auf den Punkt gebracht. Für einige ist es jetzt sicherlich nichts neues, doch ich finde es enorm wichtig, zu verstehen, wie Google funktioniert und arbeitet. Zumal ich bei diesem Fall sehr genau hingeschaut habe.

1. Neuindexierung – Was Google nach einem Relaunch zuerst macht

Google erfasst die neuen Inhalte & das Layout (z.B. mobile friendly) der Website durch Crawler (Googlebot) und legt die Seite kategorisch und verschlagwortet im Index ab. Das geschieht anhand bekannter Faktoren wie die Verwendung von Keywords, Thema der Seite usw.

Die alte Version der Website fliegt logischerweise komplett aus dem Index. Mit ihr auch die bestehenden Rankings und die zu rankenden URL´s der Seite. Das passiert nach und nach und nicht sofort. Ein manueller Crawl-Anstoss in der Search Console kann die Neuindexierung etwas beschleunigen. 301-Redirects können aber auf jeden Fall verhindern, dass Nutzer auf alte Links klicken und auf einer 404-Seite landen.

2. SERP-Performance-Tests

Nachdem Google nun die neue Website gecrawlt und indexiert hat, muss diese natürlich auch neu bewertet werden. Vor allem dann, wenn auch die Inhalte komplett neu sind. Wie kann also ein Computerprogramm wie Google nun automatisiert rankingrelevante und vergleichbare Daten wie CTR, Verweildauer und Bounce-Rate generieren? Richtig, durch Performance-Tests.

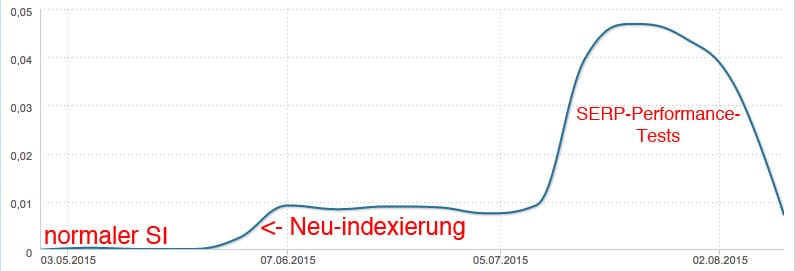

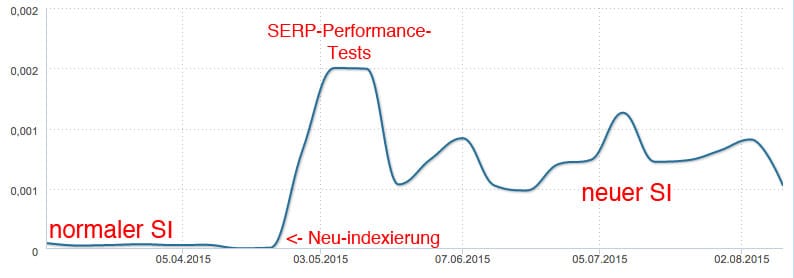

Wie auf der Abbildung oben gut zu erkennen, hat die Seite nach der Phase der Neuindexierung einen ungewöhnlich hohen kurzeitigen Sichtbarkeitsindex. Ich habe das in Echtzeit beobachtet: Google versucht, fast alle Unterseiten in den SERP zu testen. Auf verschiedenen Positionen und zu unterschiedlichen Suchanfragen. Auch haben sich die zu rankenden URL oft geändert, wenn die Seite mehrere themenähnliche Seiten hatte.

Das erzeugte den enorm hohen Sichtbarkeitsindex, der jedoch, nach den durchgeführten Tests, wieder auf Normalniveau zurückgeht. Idealerweise sollte er nach dem Relaunch sogar höher sein. In meinem Beispiel weiß ich, dass hier keine intensive SEO-Fummelei am Werk war.

Manche Unterseiten sind einige Wochen in den Rankings Achterbahn gefahren, andere waren schon nach ein paar Tagen im Keller oder ganz raus. Ich weiß leider nicht genau, nach welchen Kriterien Google diese Tests fährt und mit welchen Parametern. Eins ist jedoch ganz klar: Diese Tests sind essentiell wichtig für die Ermittlung von Nutzerdaten wie CTR, Verweildauer, Bounce-Rate usw.

Google kann auf keinem anderen Weg an solche Vergleichsdaten gelangen, als Webseiten direkt ins kalte Nutzer-Wasser zu stoßen. Die Performance-Tests werden auch nach der “heißen Phase” weiter durchgeführt, wenn auch nicht mehr so intensiv. Man kann hier also in meinem Beispiel noch keine Aussage über Erfolge und Misserfolge treffen. Man sollte nach einem Relaunch mindestens 3 Monate ins Land gehen lassen, um dann entsprechend nach zu regeln.

Für die Zweifler habe ich hier noch andere Seiten, die ebenfalls einen kompletten Relaunch hinter sich hatten. Völlig andere Branchen, völlig unterschiedliche Größen und Relevanzen. Alles Seiten, deren Relaunch wir begleitet oder umgesetzt haben. Schaut Euch einfach mal vergleichbare Seiten an. Ich bin sicher, ihr werdet etwas ähnliches beobachten können.

3. Keywords dienen der Kategorisierung & Indexierung, Nutzerdaten entscheiden das Ranking!

Man kann es nicht oft genug sagen: Keywords dienen Google nur dazu, das Thema einer Seite zu bestimmen, d.h. die Seite kategorisch zu indexieren. Eine hohe Keyword-Dichte oder gar die gezielte Optimierung auf ein Keyword entscheidet jedoch nicht über das Ranking. Das machen nämlich die Nutzerdaten!

Ihr kennt das: Eine offensichtlich hässliche Website aus dem Jahre 1890 rankt zu einem Keyword auf Platz 1. Und man fragt sich “wieso!?”. Ganz einfach: Weil diese Seite vielleicht nicht die Dorfschönheit ist, dafür aber die nette Seite, die von Nutzern als am hilfreichsten oder informativsten gesehen wird. Und das merkt auch Google. Rankings erklärt. Ende der Geschichte.

4. Google “erkennt” keinen guten Content, Google vergleicht Content

Allgemein irrt die Aussage umher, Google könne guten Content “erkennen”. Ich denke, soweit ist die Suchmaschine algorithmisch noch nicht, aber ich glaube an ein starkes Parameter-Setup mit dem Google in Vergleichen auf gute Inhalte schließen kann. Vergleicht man die gesammelten Daten mit denen aller anderen Seiten, so kann Google schon einen “Schwanzvergleich” machen.

2012 habe ich bereits, noch sehr rudimentär, von der Verweildauer als Qualitätsindikator gesprochen. Google könnte statistisch mit Wörtern und Verweildauer umgehen und sich daraus errechnen, ob ein Text oder eine Seite gelesen wurde oder nicht und wenn ja, wurde er partiell gelesen oder ganz. Im gesamten Vergleich aller themenrelevanten Seiten würde man so statistisch auf einen Qualitätsindikator kommen. Natürlich kann eine Software (noch) nicht über Stil, Emotionen und Lesbarkeit eines Textes urteilen, allerdings kann sie gut vergleichen. Und das reicht ja schon.

Kurzum: Ich denke, Suchmaschinen haben heutzutage eine Menge Möglichkeiten, Nutzersignale zu messen und zu deuten. Google Analytics, Google Chrome oder JavaScript bieten Google genug Möglichkeiten, verschiedene rankingrelevante Daten zu erheben. Ich halte OnPage-Optimierung noch immer für sehr wichtig. Allerdings ist das Leiten, Halten und Überzeugen von Nutzern auf einer Seite die entscheidende Meisterdisziplin. Eine hochpotent optimierte Seite mit massig Traffic, die aber Nutzer nicht überzeugen kann, wird langfristig gesehen keine guten Rankings einfahren.

Mögliche Ableitungen und Erkenntnisse aus dieser Beobachtung

Keine halben Sachen zu Wasser lassen

Wir wissen ja, dass Google seinen Index fortlaufend pflegt und aktualisiert. Trotzdem erscheint es extrem wichtig, dass ein Relaunch so perfekt wie möglich durchgeführt wird und Content und Usability schon bei der Neuindexierung eine hohe Qualität haben sollten. Wie wir durch den Prozess der Suchmaschinenoptimierung wissen, lassen sich Qualität und Rankings durchs Verbesserung des Themenfokus, Verwendung anderer Keywords und Umgestaltung von z.B. nutzerführenden Elementen verbessern. Allerdings wird diese laufende Optimierung wahrscheinlich nie wieder den selben intensiven “Eignungstest” durchlaufen wie bei Performance-Tests nach einem Relaunch. Ein Relaunch ist wie ein Bewerbungsgespräch: Der erste Eindruck zählt.

Man sollte sich bei einem Relaunch also nicht nur auf SEO versteifen. Natürlich ist eine technische Korrektheit, responsives Design, die Verwendung der richtigen Keywords und schnelle Ladezeiten wichtig, aber man sollte eins nie vergessen: Letztlich entscheidet der Nutzer über die Rankings, nicht die Optimierung. Setzt euch daher unbedingt mit der Seite, ihrer Funktionalität und Zielführung auseinander. Denkt euch empathisch in die Zielgruppe der Seite und überlegt was sie will und was ihr besser machen könnt, damit die Seite für den Nutzer noch toller und noch wertvoller wird. Erstellt Euch eine Persona, setzt euch mit der Zielgruppenbestimmung auseinander.

Baby-Bonus nutzen!

SEOs nennen die besseren Rankings beim Start einer frischen Seite oder nach einem Relaunch auch “Baby-Bonus”. Ich sage: Die Website solte man schon zu 100% optimiert und erwachsen in die “Baby-Bonus-Phase” schicken. Keine halben Sachen machen und keine Ausreden wie “das können wir dann ja immer noch machen”. Natürlich gibt es Monster-Projekte, Zeitdruck und knappe Ressourcen. In der Praxis sieht es deshalb oft nicht ganz so perfekt aus, man kann aber priorisieren. Konzentriert euch auf die Inhalte, die Nutzerfreundlichkeit und die Crawlbarkeit der Seite (Metas, OnPage-Basics) und alles ist gut.

Wettbewerber anschauen

Wenn Google bei den Rankings Seiten vergleicht, dann könnt ihr das auch. Schaut euch die SERP an. Was machen die Positionen 1 – 10 so besonders und was haben sie gemeinsam? Schaltet einfach für ein paar Minuten euren kritischen Kopf aus und betrachtet eine der Konkurrenzseiten mit Baby-Nutzer-Augen. Ihr werdet feststellen, dass man so sehr wertvolle Informationen darüber erhalten kann, was die Nutzer einer Branche oder eines Themas (alle sind anders!!) für wertvoll und informativ halten.

Disclaimer: Der Artikel kann nachträglich noch um Informationen erweitert oder gekürzt werden. Änderungen werden dann mit einem entsprechenden Hinweis versehen.

Dieser Artikel wurde musikalisch unterstützt von

Skrillex Mega Mix by F4mes on Mixcloud